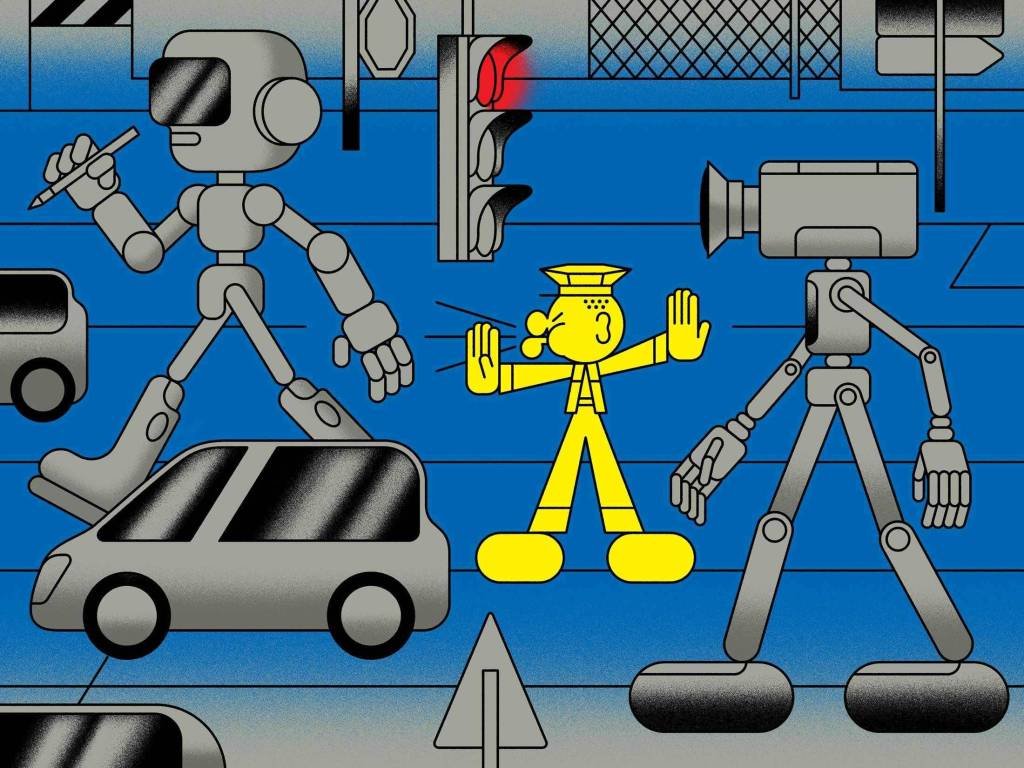

Após sucesso do ChatGPT, governos querem regular a inteligência artificial. Veja o que está em jogo

A proposta atualmente mais desenvolvida para regulamentar a IA vem da União Europeia, que emitiu pela primeira vez sua Lei de Inteligência Artificial em 2021. Entenda o impacto dela para as empresas

Bloomberg Businessweek

Publicado em 20 de março de 2023 às 18h00.

Os apelos aos governos para regular a inteligência artificial (IA) são muito anteriores ao lançamento do ChatGPT pela OpenAI no final de 2022.

Mas as autoridades não apresentaram uma abordagem para lidar com o potencial da IA para permitir a vigilância em massa, exacerbar desigualdades de longa data ou colocar humanos em perigo físico.

Com esses desafios se aproximando, o súbito surgimento da chamada IA generativa – sistemas como chatbots que criam conteúdo por conta própria – está apresentando uma série de novos desafios.

“Precisamos regular isso, precisamos de leis”, diz Janet Haven, diretora executiva da Data & Society, organização de pesquisa sem fins lucrativos de Nova York.

“A ideia de que as empresas de tecnologia conseguem produzir o que quiserem e lançá-los ao mundo e assim, a sociedade se esforça para se ajustar, mas abrir caminho para isso é um retrocesso.”

Quem quer regulamentar a IA generativa

- A proposta atualmente mais desenvolvida para regulamentar a IA vem da União Europeia, que emitiu pela primeira vez sua Lei de Inteligência Artificial em 2021.

- A legislação, cuja forma final ainda está sendo debatida, colocaria agressivas salvaguardas quando a tecnologia estiver sendo usada para “alto risco”, incluindo decisões de emprego ou em algumas operações de aplicação da lei, deixando mais espaço para experimentação com aplicativos de menor risco.

- Alguns dos legisladores por trás do ato querem designar o ChatGPT como de alto risco, uma ideia à qual outros se opõem. Como está escrito, o projeto de lei se concentra em como as tecnologias são usadas, e não nas próprias tecnologias específicas.

- Nos Estados Unidos, as autoridades locais, estaduais e federais começaram a dar alguns passos para o desenvolvimento de regras.

- O governo Biden apresentou no outono passado seu projeto para uma “Declaração de Direitos da IA”, que aborda questões como discriminação, privacidade e a capacidade dos usuários de optar por não participar de sistemas automatizados.

Onde estão os gargalos da regulação

Mas as diretrizes são voluntárias e alguns especialistas dizem que a IA generativa já levantou questões — incluindo o potencial de desinformação produzida em massa — que o projeto não aborda.

Há uma crescente preocupação de que os chatbots tornem mais difícil para as pessoas confiarem em qualquer coisa que encontrem online. “Isso faz parte da trajetória de falta de cuidado com a verdade”, diz Will McNeill, professor da Universidade de Southampton, no Reino Unido, especializado em ética da IA.

Algumas agências públicas nos EUA estão tentando limitar como as ferramentas generativas de IA são usadas antes de serem implementadas: o Departamento de Educação da cidade de Nova York proíbe o ChatGPT em seus dispositivos e redes.

Algumas instituições financeiras dos EUA também proibiram a ferramenta. Para IA de forma mais ampla, as empresas adotaram rapidamente novas diretrizes nos últimos anos, sem “aumentos substanciais” na mitigação de riscos, de acordo com uma pesquisa de 2022 do McKinsey.

Sem políticas claras, o principal obstáculo à IA parece ser os limites que as empresas que constroem tecnologia impõem a si mesmas.

“Para mim, o que vai soar o alarme é se as organizações estão se direcionando para a comercialização sem falar sobre como estão garantindo que isso seja feito de maneira responsável”, diz Steven Mills, diretor de ética de IA do Boston Consulting Group. “Ainda não temos certeza do que essas tecnologias podem fazer”.

O que as big techs pensam sobre o assunto

Empresas como Google, Microsoft e OpenAI, que estão trabalhando em IA generativa, têm falado sobre como levam a sério as preocupações éticas sobre seu trabalho.

Mas os líderes de tecnologia também vem alertando contra regulamentações excessivamente rígidas, com empresas sediadas nos EUA avisando governos ocidentais de que uma reação exagerada dará à China, que está buscando agressivamente a IA, uma vantagem geopolítica.

O ex-CEO do Google, Eric Schmidt, agora presidente do Projeto de Estudos Competitivos Especiais, sem fins lucrativos, afirmou em uma audiência no Congresso em 8 de março que “é importante que as ferramentas de IA reflitam os valores americanos e que o governo deva principalmente “trabalhar nas bordas onde ela é mal utilizada”.

De sua parte, a China já está planejando regras para limitar a IA generativa e impediu empresas de usar aplicativos ou sites que roteiam para o ChatGPT, de acordo com reportagens locais.

Alguns especialistas acreditam que essas medidas são uma tentativa de implementar um regime de censura em torno das ferramentas ou para dar uma vantagem aos concorrentes chineses. Mas os tecnólogos podem estar avançando rápido demais para que as autoridades possam acompanhar.

Tradução de Anna Maria Dalle Luche